Advice for new software devs who’ve read all those other advice essays #

https://buttondown.email/hillelwayne/archive/advice-for-new-software-devs-whove-read-all-those/

这篇文章的标题是《Advice for new software devs who’ve read all those other advice essays》。这是一篇关于给新手程序员的建议的文章,作者自称并不应该给别人提供建议。

文章提供了 13 条关于早期职业程序员的建议,其中一些是相互矛盾的。作者强调读者应该谨慎思考,并评估建议如何适用于自己的情况。此外,文章还提到了一些具体的建议,例如阅读《Debugging: The 9 Rules》这本书,尝试不同的编程方式,了解工具的隐藏功能,与公司其他部门的人交流等。

最后,作者提醒读者要保持谨慎并享受编程的过程。

这篇文章提供了一些有用的建议,可以帮助新手程序员在职业生涯的早期阶段更好地发展。读者应该根据自己的情况和需求来评估这些建议的适用性,并结合自己的经验和判断做出决策。

HN 评论 294 comments | 作者:BerislavLopac | 16 hours ago #

https://news.ycombinator.com/item?id=38706697

有人分享了他与一位初级程序员和一位不太初级的程序员一起合作的经历。这两位程序员都是所谓的“Right Way Guys”,他们在一个小型项目上过度工程化,关注细节而忽略了核心功能。

有人认为这种行为并不是“Right Way Guys”,而是“Bikeshedding”,即在重要问题上花费过多的时间和精力,而忽视了重要问题。

有人认为在有限的用户基础下,过度关注细节而忽视核心功能是一种浪费时间和资源的行为。

有人认为在初级开发人员中,这种行为可能是因为他们更容易理解和讨论细节,而忽视了项目的更重要部分。

有人认为在某些情况下,使用已知的工具和技术可能是合理的选择,而不是试图学习新的技术。

有人认为在成熟的产品中,关注文档、部署和可扩展性等细节是有意义的,但在初期阶段可能并不必要。

有人认为在编写代码时,需要在“Right Way”和避免“Bikeshedding”之间取得平衡。

有人认为过度关注细节和过度工程化会导致项目变得更糟糕。

有人认为在软件开发中,实用主义和基于现实的观点总是优于“Right Way”主义。

这些是对该帖子评论观点的摘要,涵盖了对“Right Way Guys”行为的不同看法和讨论。

Implementation of Mamba in one file of PyTorch #

https://github.com/johnma2006/mamba-minimal

这是一个名为"Mamba-minimal"的 GitHub 项目,它是一个简单、最小化的 PyTorch 实现的 Mamba 模型。该项目的目标是提供一个简化、可读性强的代码实现,以及与官方实现相等的数值输出。它包含了一个演示示例,展示了如何使用该模型进行提示完成。该项目的作者还提供了参考文献和官方实现的链接。

详细分析:

该 GitHub 项目的名称是"Mamba-minimal",它是一个简化的、最小化的 PyTorch 实现的 Mamba 模型。

该项目的目标是提供一个简化、可读性强的代码实现,并且保持与官方实现相等的数值输出。

该项目的代码文件包括一个 README.md 文件、一个 demo.ipynb 文件和一个 model.py 文件。

README.md 文件提供了关于项目的简介和使用说明。

demo.ipynb 文件包含了使用该模型进行提示完成的示例代码。

model.py 文件包含了 Mamba 模型的实现代码。

该项目的作者还提供了参考文献,引用了 Mamba 模型的原始论文和官方实现的链接。

该项目的作者还指出,该实现并没有包含官方实现中的优化部分,因此在速度上可能不如官方实现。

该项目的作者还提到,该实现没有进行适当的参数初始化,但可以通过添加代码来实现。

该项目的作者还提供了 Mamba 模型的预训练权重和一个自动分词器的使用示例代码。

HN 评论 90 comments | 作者:johnma2006 | 11 hours ago #

https://news.ycombinator.com/item?id=38708730

有人评论说,他们之前开发了一个库,可以将大部分共享的模型代码提取出来,用大约 100 行代码实现多个模型。

有人提到了 xformers 库,该库也在解决相同的问题,但重点更多地放在使用 triton 提供高性能的 transformer 模块。然而,他们在使用该库时遇到了一些运行时错误。

有人提到 Mamba 是一个干净的实现,他们避免查看其他实现,以确保他们的实现是一个独立的实现。

有人提到他自己实现了 Mamba,并且对 einops 和 einsum 这些库表示了一些观点。

有人提到 Mamba 相对于传统的 transformer 模型在训练和推理时更加高效。

有人提到 Mamba 的潜在性能优势,包括更低的内存消耗和更高的计算效率。

有人提到 Mamba 是一个线性的状态空间模型,与 RNN/LSTM 变体不同,它具有更高的并行性。

有人提到 Mamba 的实现非常简洁易懂,但也有人对 einops 表示了不同的看法。

这些是帖子中的一些评论观点摘要。请注意,这些摘要可能不包含所有评论,而且评论观点是来自匿名用户,可能存在个人偏见。

Volkswagen, Porsche, and Audi say they will use Tesla’s EV charging plug #

https://www.theverge.com/2023/12/19/24008426/volkswagen-audi-porsche-tesla-nacs-ev-charging-plug

文章标题为《大众、保时捷和奥迪终于表示将采用特斯拉的电动汽车充电插头》。文章指出,大众集团(Volkswagen Group)宣布将采用特斯拉的电动汽车充电标准,这使其成为最后一个向特斯拉低头的主要汽车制造商。大众表示正在研究适配器解决方案,以便其现有的电动汽车车主可以使用特斯拉的超级充电网络,并计划在 2025 年推出相应的解决方案。同年,大众的新电动汽车将原生地安装特斯拉的充电插头。大众表示,这项协议将使其客户能够在北美地区访问 15,000 个超级充电站。

这篇文章还提到,大众是在这方面非常晚的一批。2022 年 11 月,特斯拉宣布将其充电技术更名为北美充电标准(NACS),并向其他汽车制造商开放。福特率先加入,然后是通用汽车,接着其他汽车制造商也纷纷加入。大众集团作为全球最大的汽车制造商之一,旗下拥有奥迪、宝马、保时捷和兰博基尼等品牌,此前一直保持沉默。直到最近,大众的电动汽车充电子公司 Electrify America 开始添加特斯拉的充电插头。随后,德国的其他汽车制造商也纷纷加入,包括宝马、MINI 和奔驰。

特斯拉的超级充电网络被广泛认为优于许多第三方电动汽车充电站,后者大多采用 CCS 插头和较少使用的 CHAdeMO 充电标准。特斯拉表示,其全球拥有 45,000 个超级充电站,其中 12,000 个位于美国。与其他电动汽车充电站在软件故障和故障充电器方面遇到困难不同,特斯拉表示其超级充电站的可靠性几乎完美。公司表示,去年超级充电站的平均正常运行时间达到 99.95%,略低于 2021 年的 99.96%。

现在,随着大众的加入,特斯拉可以将所有注意力集中在最后一个真正的抵抗者身上:Stellantis,该公司拥有 Jeep、克莱斯勒、Ram、道奇、标致、菲亚特等品牌。

HN 评论 477 comments | 作者:thunderbong | 10 hours ago #

https://news.ycombinator.com/item?id=38709319

有人提到,他是 Starlight Charging 的创始人,他们正在开发用于多户公寓的低成本 L2 充电器。对他们来说,插入即充电是必不可少的。

有人指出,目前仍存在一个未解决的问题,即充电桩到车辆之间缺乏关于支付/电力线通信的标准协议。他们提到了 OCPP 2.0.1 和 ISO 15118,这些标准理论上可以实现“插入即充电”的功能,即驾驶员只需将车辆停在充电站旁边,插入插头,充电立即开始,无需使用多个不同制造商的应用程序。

特斯拉拒绝实施 OCPP,因为他们目前拥有一个独立的闭环系统,并且不想放开对支付的控制。

有人问为什么插入即充电如此重要,提到自己使用过带有和不带有该功能的充电器,认为它并没有带来巨大的改进。

有人回答说,如果你曾经在电动汽车上进行长途旅行,你就会明白使用应用程序进行充电是多么糟糕的体验,应用程序无法正常工作,充电器无法启动,支付无法完成。他们希望能够像加油一样简单地充电。

有人建议在电动汽车充电点实施“触碰并支付”支付方式,而不是将支付集成到充电标准中,以避免过度复杂化。

有人提到,如果通过充电插头发送支付信息,就必须担心支付信息是否存储在车辆中,如果车辆存在任何安全漏洞,包括充电口,支付信息可能会被盗取。

有人建议在充电桩上安装刷卡器,以解决借用电动汽车的情况。

有人提出了一种假设的标准:充电桩允许车辆打开低带宽互联网连接,车辆使用该连接与第三方服务(如特斯拉/Visa 等)建立加密通道,提供车辆识别号码、密码和充电桩 ID,充电桩从第三方获取支付信息。

有人认为将支付集成到充电标准中会带来过度复杂化,并提到了一些技术和安全方面的问题。

有人建议使用类似于加油站的信用卡终端,认为这是一个简单的解决方案。

有人提到,英国的无接触支付已经非常普及,几乎没有问题。

有人讨论了使用无接触支付的一些限制和问题。

有人认为无接触支付是一个方便的措施,但可能不是充电基础设施的理想机制。

有人提到,无接触支付在澳大利亚也非常普及,他已经五年没有携带钱包了。

有人认为插入即充电可以使充电体验与加油体验相同,对于不熟悉技术的用户来说更容易理解。

有人提出了一种不同的观点,认为为什么不像加油一样,将支付作为一个独立的过程,而不是与充电集成。

有人建议使用类似于加油站的信用卡终端,认为这是一个简单的解决方案。

有人认为充电公司应该接受更普遍的支付系统,如信用卡,这样消费者就不需要为每个充电网络下载一个应用程序。

有人提到,一些充电桩已经在机器上使用触碰和支付的方式,无需使用应用程序。

有人认为这个问题可以通过法律规定来解决,要求充电站接受更普遍的支付系统,如信用卡。

有人提到,英国已经颁布了一项新法律,要求大多数充电桩接受信用卡支付。

有人认为应该通过法律规定来解决这个问题,标准化支付系统,以便快速、标准化地在各个公司之间建立充电基础设施。

有人提到,免费充电由汽油税资助可能是一个解决方案。

有人认为这个解决方案可能行得通,但在美国这是一个革命性的解决方案,政治上比废除圣诞节还要困难。

有人认为较低收入人群不应该为富人购买电动汽车提供补贴。

有人认为充电公司不愿意接受标准化支付是因为他们可以通过应用程序从消费者那里获取数据。

有人提到,英国的充电桩已经开始接受信用卡支付,并且政府已经颁布了一项新法律,要求大多数充电桩接受信用卡支付。

有人认为充电公司应该提供接受信用卡支付的解决方案,以避免用户下载应用程序。

有人提到,一些充电桩已经在机器上使用触碰和支付的方式,无需使用应用程序。

有人认为充电公司应该通过法律规定来强制接受触碰和支付的方式。

有人认为特斯拉和 NACS 的充电网络正在被广泛采用。

这些是帖子中的一些观点和讨论。请注意,这些观点来自于帖子的评论,可能代表个别用户的观点,并不一定代表广泛共识。

Tesla blamed drivers for failures of parts it long knew were defective #

https://www.reuters.com/investigates/special-report/tesla-musk-steering-suspension/

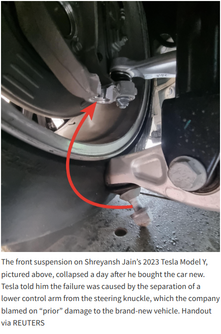

特斯拉在其长期已知的有缺陷零部件出现问题时,将责任归咎于司机。根据路透社对特斯拉文件的审查,特斯拉早已了解到缺陷的程度比向消费者和安全监管机构露的要多得多。

特斯拉的记录显示,成千上万的特斯拉车主在悬挂或转向部件过早失效方面遇到了问题。这些慢性失效问题至少可以追溯到七年前,并且涵盖了特斯拉的整个车型系列,从中国到美国再到欧洲,根据记录和与 20 多名顾客以及 9 名前特斯拉经理或服务技术人员的采访。

特斯拉在声明中否认了一些悬挂和转向问题,声称这些问题是特斯拉车主滥用车辆造成的。特斯拉曾指示其服务中心在与发生悬挂问题的顾客交流时使用相同的解释,指责 “车辆滥用”,比如 “撞到路缘石或其他过度强烈的冲击”。

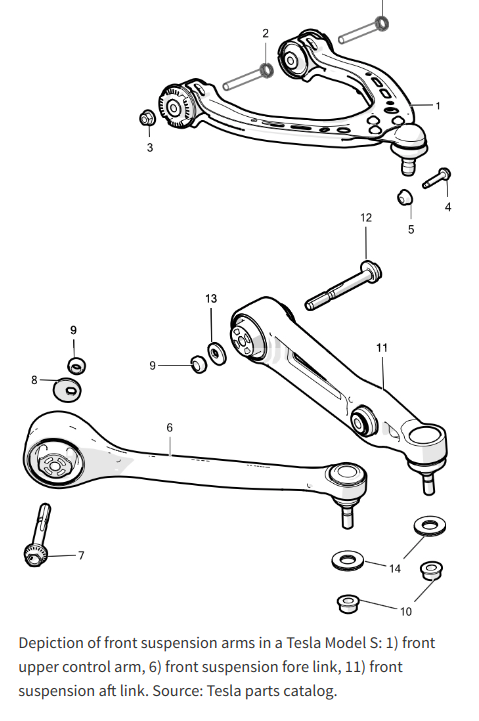

特斯拉的记录显示,悬挂连接件和转向齿条等低技术悬挂连接件经常出现问题。而较复杂和昂贵的部件,如半轴和转向齿条,则经常失效。特斯拉的工程师内部称这些部件存在缺陷或高故障率。特斯拉曾多次对这些部件进行重新设计,并讨论是否向供应商追回费用。

特斯拉在中国召回了部分零部件,但没有在美国进行召回。特斯拉在美国监管机构面前称这些失效是由 “司机滥用” 造成的。特斯拉还曾在 2019 年的一份备忘录中指示其服务中心向遇到悬挂问题的顾客使用同样的解释。特斯拉使用 “滥用” 和 “错误使用” 这些术语在保修合同中,以拒绝索赔或维修费用。

特斯拉在维修保修上面临的巨大成本使得公司的盈利能力受到威胁。在 2018 年第四季度,特斯拉平均为每辆特斯拉支付了近 500 美元的维修费用,而由于高额保修和善意维修而造成的损失达到了 2.63 亿美元,几乎是特斯拉当季盈利的两倍。

一些美国的顾客不得不支付 1000 多美元的费用来修复悬挂连接件,并且特斯拉的记录显示许多欧洲顾客对支付更换费用感到沮丧。特斯拉在 2013 年至 2018 年间生产的 Model S 和 Model X 车型面临了一起潜在的集体诉讼,指控特斯拉知道这些车辆存在 “悬挂缺陷”,但拒绝支付修理费用,即使车辆仍在保修期内。这起集体诉讼的其他两名原告自愿撤销了他们的诉讼,但可以重新提起类似的案件。

特斯拉在 2018 年以来的美国发起了九次召回,涉及转向和悬挂问题。大多数召回涉及的车辆数量相对较小。特斯拉工程师在 2022 年仍在检查悬挂连接件的问题。特斯拉在 2020 年 9 月向美国监管机构的一封信中否认了这些悬挂连接件存在任何缺陷,并表示不会召回这部分产品。

特斯拉的记录显示,公司对悬挂和转向问题的处理反映了马斯克企业帝国的一贯模式,即对顾客、工人和其他人提出的安全或其他问题置之不理,而急于推出新产品或扩大销售。特斯拉在维修和保修问题上的处理方式也与马斯克的其他公司类似。

HN 评论 288 comments | 作者:musiciangames | 13 hours ago #

https://news.ycombinator.com/item?id=38707589

评论者表示特斯拉的视觉系统存在问题,导致在雾天和单车道上出现了危险的情况。

特斯拉的反向视觉系统存在问题,经常发出错误的警报。

特斯拉的紧急制动系统也存在问题,需要进行维修。

特斯拉的悬挂系统、车窗噪音和车门关闭难度等方面也被提到。

评论者还提到了特斯拉购买和交付的便利性。

这些评论主要涉及特斯拉汽车的质量和性能问题。请注意,这些评论仅代表个人观点,可能不代表所有用户的意见。

High-Speed Large Language Model Serving on PCs with Consumer-Grade GPUs #

https://github.com/SJTU-IPADS/PowerInfer

根据提供的链接,这是一个名为 PowerInfer 的项目,它是一个在个人电脑上使用消费级 GPU 进行高速大型语言模型服务的引擎。该项目利用了语言模型推理中的高局部性,通过预加载热激活的神经元到 GPU 上进行快速访问,同时将冷激活的神经元在 CPU 上计算,从而显著降低了 GPU 内存需求和 CPU-GPU 数据传输。此外,PowerInfer 还集成了自适应预测器和神经元感知的稀疏运算符,优化了神经元激活和计算稀疏性的效率。

评估结果显示,PowerInfer 在单个 NVIDIA RTX 4090 GPU 上的各种语言模型(包括 OPT-175B)上实现了平均每秒生成 13.20 个标记的速率,峰值达到 29.08 个标记/秒,仅比顶级服务器级 A100 GPU 低 18%,这在保持模型准确性的同时,比 llama.cpp 快了多达 11.69 倍。

PowerInfer 具有以下特点:

基于局部性的设计:利用稀疏激活和“热”/“冷”神经元的概念,实现高效的语言模型推理,确保在较低资源需求下实现高速度。

混合 CPU/GPU 利用:无缝集成 CPU 和 GPU 的内存/计算能力,实现负载均衡和更快的处理速度。

灵活易用:与流行的 ReLU 稀疏模型兼容,易于集成和使用。

本地部署便利:专为在消费级硬件上进行本地部署进行了深度优化,实现低延迟的语言模型推理和服务。

向后兼容性:虽然与 llama.cpp 不同,但您可以像使用 llama.cpp 一样使用大多数示例,如服务器和批量生成。PowerInfer 还支持使用 llama.cpp 的模型权重进行推理,以实现兼容性,但不会带来性能提升。

PowerInfer 还提供了安装、模型权重下载、设置和安装、构建、推理、量化、评估等方面的详细说明和指南。您可以通过提供的链接详细了解 PowerInfer 项目的内容和用法。

参考链接:PowerInfer GitHub Repository

HN 评论 50 comments | 作者:dataminer | 11 hours ago #

https://news.ycombinator.com/item?id=38708585

根据提供的链接,这篇帖子是关于在个人电脑上使用消费级 GPU 进行高速大型语言模型服务的。

评论中的观点包括对模型中的“热”和“冷”神经元的理解、对使用 ReLU 激活函数的模型的讨论、对法律影响的猜测、对模型开发过程中的优化和自动化的讨论,以及对其他相关话题的评论。

总体而言,这篇帖子和评论主要关注了模型优化和性能提升的话题,以及与模型开发和部署相关的法律和技术问题。

LLM in a Flash: Efficient LLM Inference with Limited Memory #

https://huggingface.co/papers/2312.11514

这篇文章的标题是《LLM in a flash: Efficient Large Language Model Inference with Limited Memory》。该文章探讨了在具有有限 DRAM 容量的设备上高效运行超过可用 DRAM 容量的大型语言模型(LLMs)的挑战,并提出了一种解决方案。该方法通过将模型参数存储在闪存中,并按需将其传输到 DRAM 中,来克服这一挑战。

文章介绍了两个主要技术:一是通过重新使用先前激活的神经元来减少数据传输量的"windowing"策略,二是通过增加从闪存读取的数据块的大小来利用闪存的顺序数据访问优势的"row-column bundling"策略。这些方法使得可以在可用 DRAM 容量的两倍大小的模型上运行,并且与 CPU 和 GPU 上的朴素加载方法相比,推理速度分别提高了 4-5 倍和 20-25 倍。该方法的集成了稀疏性感知、上下文自适应加载和面向硬件的设计,为在具有有限内存的设备上有效推理 LLMs 铺平了道路。

文章的摘要提供了关于如何在具有有限内存的设备上高效运行大型语言模型的方法。具体来说,文章介绍了通过将模型参数存储在闪存中,并按需将其传输到 DRAM 中的解决方案。文章还介绍了两个关键技术:一是通过重新使用先前激活的神经元来减少数据传输量的"windowing"策略,二是通过增加从闪存读取的数据块的大小来利用闪存的顺序数据访问优势的"row-column bundling"策略。这些方法使得可以在可用 DRAM 容量的两倍大小的模型上运行,并且推理速度显著提高。

HN 评论 48 comments | 作者:ghshephard | 22 hours ago #

https://news.ycombinator.com/item?id=38704982

论文建议使用稀疏性和预测技术来提高模型加载性能,尤其是在加载来自闪存存储器的 Feed Forward Network (FFN)时。

通过预测 ReLU 层的输出而不是 FFN 层的输入,可以获得更好的稀疏性,从而跳过加载大部分 FFN 行的步骤。

论文还提出了窗口化和行列绑定等技术,以最小化数据传输并提高闪存存储器的吞吐量。

评论中还讨论了模型加载对性能的影响、内存需求以及与其他相关论文的关系。

这些观点主要涵盖了论文的主要内容和技术贡献。

Rite Aid banned from using AI facial recognition for five years #

根据 FTC 官方新闻稿的摘要,Rite Aid 被禁止在未采取合理保护措施的情况下使用人工智能面部识别技术,以解决联邦贸易委员会指控该零售商在数百家门店中使用面部识别技术时未能实施合理程序并防止对消费者造成伤害的问题。禁令将持续五年。

根据 FTC 的指控,Rite Aid 在 2012 年至 2020 年期间部署了基于人工智能的面部识别技术,以识别可能涉嫌入店行窃或其他问题行为的顾客。然而,FTC 指控称该公司未采取合理措施防止对消费者造成伤害,导致员工错误地指控消费者有不当行为,因为面部识别技术错误地将消费者标记为之前被识别为店窃贼或其他捣乱分子的人。

为了解决对 2010 年委员会数据安全命令的违反指控,Rite Aid 还将被要求实施强有力的信息安全计划,并由公司高层监督。

FTC 的投诉还指出,Rite Aid 未能充分实施全面的信息安全计划,违反了 2010 年的数据安全命令。此外,禁令还要求 Rite Aid 删除任何因其面部识别系统而收集的图像或照片,以及使用这些图像和照片开发的任何算法或其他产品。禁令还要求 Rite Aid 在其门店中明确告知消费者使用面部识别或其他生物特征监控技术的情况,并在基于此类系统输出采取某种行动时通知消费者。此外,Rite Aid 还必须在五年内删除其收集的任何生物特征信息,并实施数据安全计划来保护和安全存储与其供应商共享的个人信息。

禁令将在破产法院和联邦地区法院批准后生效,并经过委员会对 2010 年命令的修改。

这项禁令的目的是保护消费者免受不公平的生物特征监控和数据安全实践的伤害,并确保零售商在使用面部识别技术时采取合理的措施以防止对消费者造成伤害。

请注意,以上摘要仅基于 FTC 的新闻稿,具体细节和背景信息可能需要参考原始文章以获得更全面的了解。

HN 评论 79 comments | 作者:commoner | 22 hours ago #

https://news.ycombinator.com/item?id=38704830

这篇帖子讨论了 Rite Aid 被禁止使用人工智能面部识别技术五年的观点。以下是评论的摘要:

有人分享了自己在加利福尼亚的一家 Rite Aid 店铺看到并反对面部识别系统的经历,并呼吁更多人表达自己的观点,以影响商家的决策。

有人询问如何区分面部识别系统和普通的安全摄像头,以及如何发现这些摄像头正在使用面部识别技术。

有人分享了 Rite Aid 面部识别系统的一些细节,包括摄像头的外观和 FTC 报告中关于该系统的一些信息。

有人讨论了面部识别技术在餐厅中的使用,并提到了一个关于面部识别系统崩溃并显示检测日志的故事。

有人分享了 FTC 报告中关于 Rite Aid 面部识别系统的一些细节,包括关于数据库和图片质量的信息。

有人讨论了面部识别技术在零售行业中的使用,提到了对于小额盗窃事件,使用面部识别系统可以帮助商家追踪同一罪犯并进行起诉。

有人担心面部识别技术可能被滥用,提到了类似浏览器 Cookie 和软件最初被用于正当目的,但后来被滥用的情况。

有人分享了一篇关于 Rite Aid 面部识别系统的调查报道,并提到了该系统的工作原理和使用情况。

有人讨论了面部识别技术在中国的使用,并提到了中国在非洲和拉丁美洲的投资以及对数据的控制。

有人讨论了 Rite Aid 违反数据安全命令的情况,并提到了监管机构对于监督服务提供商的责任。

有人质疑为什么 FTC 负责此事,而不是其他机构,并提到了 FTC 的权力和责任。

有人对美国的隐私法律进行了批评,并认为隐私保护的状况不容乐观。

有人讨论了面部识别技术的准确性和隐私问题,并提到了 NIST 的报告。

有人对 FTC 的决定表示不满,认为这对 Rite Aid 来说是一个胜利,而不是对消费者来说。

请注意,这只是评论中的一些观点摘要,并不代表全部观点。

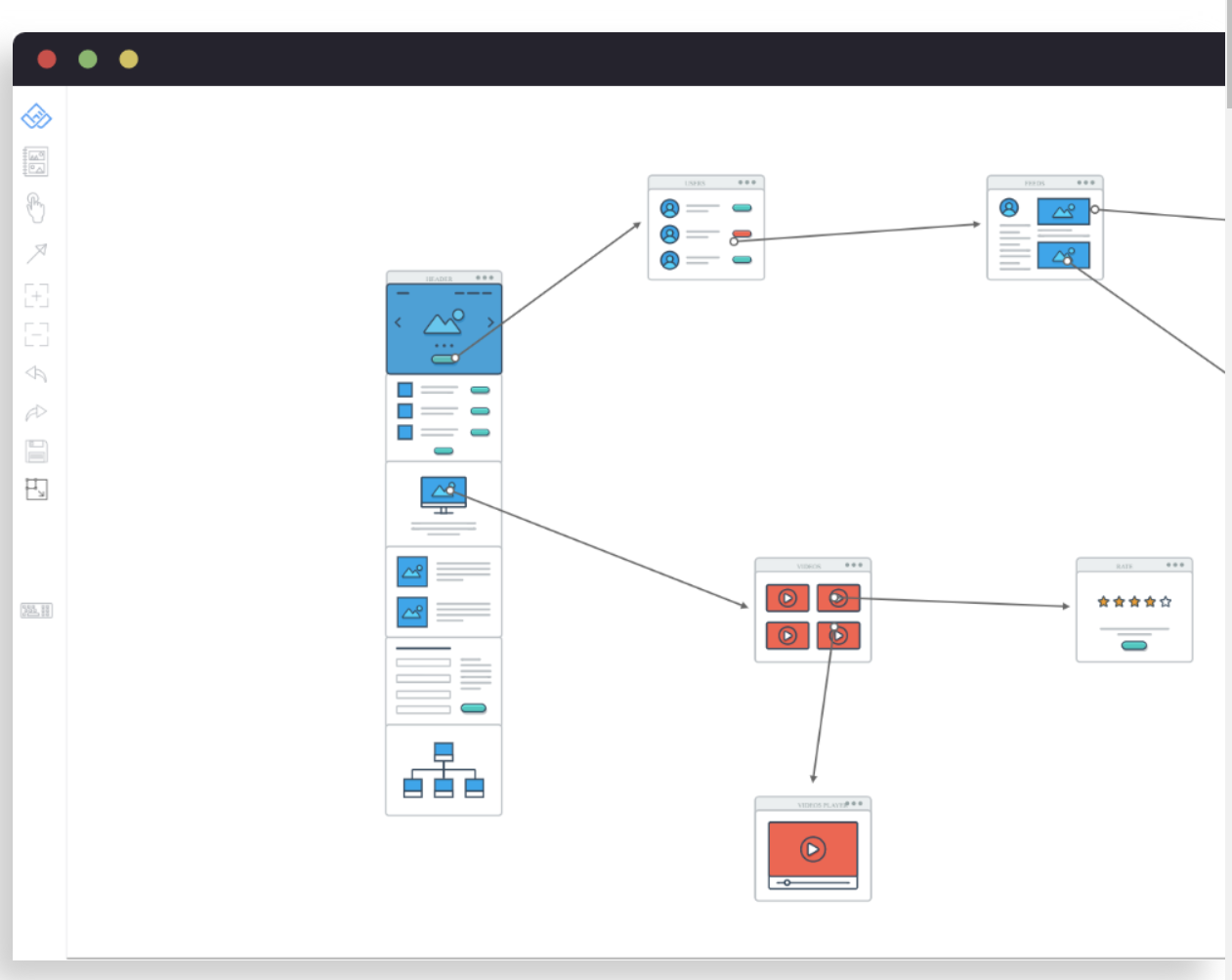

Wireflow – free, online, open source tool for creating user-flow prototypes #

Wireflow.co 是一个免费、在线的开源工具,用于创建漂亮的用户流程原型。它不需要 Photoshop 技能。Wireflow 拥有 100 多个自定义构建的图形/卡片,涵盖了大多数的 Web 元素、交互和使用案例。

它支持实时协作,您可以邀请同事一起实时设计下一个项目的用户流程。您可以决定谁可以访问您正在工作的项目/房间,以及它是公开还是私有的。

Wireflow 还内置了实时聊天功能,可以让您与团队成员进行沟通,并在实时协作中保持在同一个应用程序中。它具有简单、简洁、易于使用的界面,无需安装或具备任何复杂软件的先前经验。

Wireflow 的目标是简化项目计划和头脑风暴的早期阶段的流程。它是一个原型,旨在验证一个简单而有用的应用程序的想法,可以节省大量时间。请注意,它是有缺陷的和免费的。

您可以在 Wireflow.co 上开始设计用户流程原型,并使用其中的工具和功能进行操作。

HN 评论 23 comments | 作者:Brajeshwar | 9 hours ago #

https://news.ycombinator.com/item?id=38710030

有人对 Wireflow 的维护情况表示担忧,指出 GitHub 上的主要分支已经多年没有更新。

有人提到 Wireflow 最初是使用 Meteor 创建的,后来进行了 React 的重写,但仍然没有保存数据的功能。

有人建议在 https://discourse.opensourcedesign.net/上寻求反馈,那里有一些开源项目中的用户体验设计师。

有人提到自己曾经为该项目贡献了 Dockerfile,但认为由于该项目是由一个应用开发工作室开发的,他们可能有不同的优先事项。

有人提到对于类似的项目,他们使用 excalidraw,但希望能够扩展它以添加"flow"设计。

有人询问是否有类似的项目使用 Vue.js 编写。

有人询问什么是用户流程原型,得到了解释。

有人提到 Wireflow 的网页加载有问题。

还有其他一些评论提到了对 Wireflow 的兴趣和使用体验。

这些是帖子中的一些观点和讨论。请注意,这只是一个摘要,可能并不包含所有评论。您可以点击链接查看完整的帖子和评论。